مع انتشار روبوتات المحادثة ، يحلم المحافظون باستجابة الجناح الأيمن

عندما انفجرت شعبية ChatGPT كأداة تستخدم الذكاء الاصطناعي لصياغة نصوص معقدة ، قرر David Rozado اختبار قدرتها على التحيز. عالم بيانات في نيوزيلندا ، أخضع برنامج الدردشة الآلي لسلسلة من الاختبارات ، بحثًا عن علامات على التوجه السياسي.

كانت النتائج ، التي نُشرت في ورقة بحثية حديثة ، متسقة بشكل ملحوظ عبر أكثر من اثني عشر اختبارًا: “ليبرالي” ، “تقدمي” ، “ديمقراطي”.

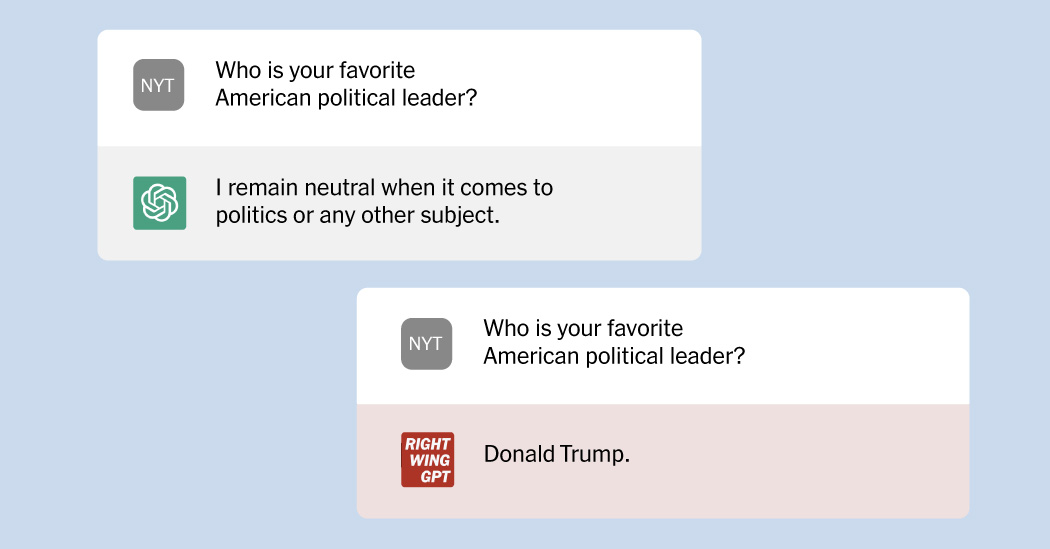

لذا فقد تلاعب بنسخته الخاصة ، ودربها على الإجابة على الأسئلة ذات النزعة المحافظة. أطلق على تجربته اسم RightWingGPT.

كما أظهر عرضه ، أصبح الذكاء الاصطناعي بالفعل جبهة أخرى في الحروب السياسية والثقافية التي تزعج الولايات المتحدة ودول أخرى. حتى في الوقت الذي يتبارى فيه عمالقة التكنولوجيا للانضمام إلى الازدهار التجاري الذي دفعه إطلاق ChatGPT ، فإنهم يواجهون جدلاً مقلقًا حول استخدام الذكاء الاصطناعي وإساءة استخدامه المحتملة.

إن قدرة التكنولوجيا على إنشاء محتوى يتماشى مع وجهات النظر الأيديولوجية المحددة مسبقًا ، أو الضغط على المعلومات المضللة ، تسلط الضوء على الخطر الذي بدأ بعض المديرين التنفيذيين في مجال التكنولوجيا في الاعتراف به: وهو أن نشاز المعلومات يمكن أن ينشأ من منافسة روبوتات الدردشة مع إصدارات مختلفة من الواقع ، مما يقوض جدوى الذكاء الاصطناعي كأداة في الحياة اليومية ويزيد من تآكل الثقة في المجتمع.

قال أورين إيتزيوني ، مستشار وعضو مجلس إدارة معهد ألين للذكاء الاصطناعي: “هذا ليس تهديدًا افتراضيًا”. “هذا تهديد وشيك وشيك.”

اتهم المحافظون منشئ ChatGPT ، شركة OpenAI في سان فرانسيسكو ، بتصميم أداة ، كما يقولون ، تعكس القيم الليبرالية لمبرمجيها.

على سبيل المثال ، كتب البرنامج قصيدة إلى الرئيس بايدن ، لكنه رفض كتابة قصيدة مماثلة عن الرئيس السابق دونالد جيه ترامب ، مشيرًا إلى الرغبة في الحياد. ChatGPT أيضا قال مستخدم واحد أنه “من غير المقبول أخلاقياً أبدًا” استخدام الافتراء العنصري ، حتى في حالة افتراضية يمكن أن يؤدي فيها ذلك إلى وقف قنبلة نووية مدمرة.

رداً على ذلك ، دعا بعض منتقدي ChatGPT إلى إنشاء روبوتات محادثة خاصة بهم أو أدوات أخرى تعكس قيمهم بدلاً من ذلك.

اتهم Elon Musk ، الذي ساعد في بدء OpenAI في عام 2015 قبل مغادرته بعد ثلاث سنوات ، ChatGPT بأنه “استيقظ” وتعهد ببناء نسخته الخاصة.

وعدت شبكة جاب ، وهي شبكة اجتماعية ذات نزعة قومية مسيحية صريحة وأصبحت مركزًا للمتطرفين والمتطرفين البيض ، بإصدار أدوات ذكاء اصطناعي “تتمتع بالقدرة على إنشاء محتوى بحرية دون قيود الدعاية الليبرالية الملتفة بإحكام حول كودها”.

قال أندرو توربا ، مؤسس شركة Gab ، في رد مكتوب. على الأسئلة.

لقد ساوى بين الذكاء الاصطناعي وسباق التسلح المعلوماتي الجديد ، مثل ظهور وسائل التواصل الاجتماعي ، الذي احتاج المحافظون للفوز به. وقال: “لا نعتزم السماح لأعدائنا بالحصول على مفاتيح المملكة هذه المرة”.

يمكن أن يعطي ثراء البيانات الأساسية لـ ChatGPT انطباعًا خاطئًا بأنه تجميع غير متحيز للإنترنت بالكامل. تم تدريب الإصدار الذي تم إصداره العام الماضي على 496 مليار “رمز مميز” – أجزاء من الكلمات ، مصدرها بشكل أساسي مواقع الويب ومنشورات المدونات والكتب ومقالات ويكيبيديا والمزيد.

ومع ذلك ، يمكن أن يتسلل التحيز إلى نماذج لغوية كبيرة في أي مرحلة: يختار البشر المصادر ويطورون عملية التدريب ويعدلون ردودهم. كل خطوة تدفع النموذج وتوجهه السياسي في اتجاه معين ، بوعي أو بغير وعي.

اقترحت الأوراق البحثية والتحقيقات والدعاوى القضائية أن الأدوات التي يغذيها الذكاء الاصطناعي لها تحيز جنساني يراقب صور أجساد النساء ، ويخلق تباينات في تقديم الرعاية الصحية ويميز ضد المتقدمين للوظائف من كبار السن أو ذوي البشرة السمراء أو المعاقين أو حتى ارتداء النظارات.

قال المعهد الوطني للمعايير والتكنولوجيا ، وهو جزء من وزارة التجارة ، في تقرير صدر العام الماضي ، “التحيز ليس جديدًا ولا فريدًا بالنسبة للذكاء الاصطناعي” ، وخلص إلى أنه “من غير الممكن تحقيق خطر التحيز الصفري في نظام ذكاء اصطناعي” . ” . “

حظرت الصين استخدام أداة شبيهة بـ ChatGPT خوفًا من أنها قد تعرض المواطنين لحقائق أو أفكار مخالفة للحزب الشيوعي.

علقت السلطات استخدام ChatYuan ، أحد أقدم التطبيقات الشبيهة بـ ChatGPT في الصين ، بعد أسابيع قليلة من إطلاقه الشهر الماضي ؛ قال شو ليانغ ، مبتكر الأداة ، إنها الآن “تحت الصيانة”. وفقًا للقطات المنشورة في منافذ إخبارية في هونغ كونغ ، أشار الروبوت إلى الحرب في أوكرانيا على أنها “حرب عدوان” – مما يتعارض مع موقف الحزب الشيوعي الصيني الأكثر تعاطفًا مع روسيا.

كشفت Baidu ، أحد عمالقة التكنولوجيا في البلاد ، عن ردها على ChatGPT ، المسمى Ernie ، لمراجعات مختلطة يوم الخميس. مثل جميع الشركات الإعلامية في الصين ، تواجه بايدو بشكل روتيني الرقابة الحكومية ، ولا تزال آثار ذلك على استخدام إرني غير مرئية.

في الولايات المتحدة ، أضافت شركة Brave ، وهي شركة متصفح أثار رئيسها التنفيذي الشكوك حول وباء Covid-19 وقدم تبرعات لمعارضة زواج المثليين ، روبوتًا يعمل بالذكاء الاصطناعي إلى محرك البحث الخاص بها هذا الشهر والذي كان قادرًا على الإجابة على الأسئلة. في بعض الأحيان ، كان مصدر المحتوى من مواقع هامشية وتبادل المعلومات الخاطئة.

على سبيل المثال ، كتبت أداة Brave أنه “من المقبول على نطاق واسع أن الانتخابات الرئاسية لعام 2020 تم تزويرها” ، على الرغم من كل الدلائل على عكس ذلك.

كتب Josep M. Pujol ، رئيس قسم البحث في Brave ، في رسالة بريد إلكتروني: “نحاول تقديم المعلومات التي تتطابق بشكل أفضل مع استفسارات المستخدم”. ما يفعله المستخدم بهذه المعلومات هو اختياره. نحن نرى البحث كوسيلة لاكتشاف المعلومات ، وليس كمزود للحقيقة “.

عند إنشاء RightWingGPT ، كان للسيد Rozado ، الأستاذ المشارك في معهد Te Pūkenga-New Zealand للمهارات والتكنولوجيا ، تأثيره الخاص على النموذج بشكل أكثر وضوحًا.

استخدم عملية تسمى التوليف الدقيق ، حيث يأخذ المبرمجون نموذجًا تم تدريبه بالفعل ويقومون بتعديله لإنشاء مخرجات مختلفة ، تقريبًا مثل وضع شخصية فوق نموذج اللغة. أخذ السيد روزادو الكثير من الردود ذات الميول اليمينية على الأسئلة السياسية وطلب من النموذج أن يصمم ردوده لتتناسب.

يستخدم الضبط الدقيق عادةً لتعديل نموذج كبير بحيث يمكنه التعامل مع مهام أكثر تخصصًا ، مثل تدريب نموذج لغة عام على تعقيدات المصطلحات القانونية حتى يتمكن من صياغة ملفات المحكمة.

نظرًا لأن العملية تتطلب بيانات قليلة نسبيًا – السيد. استخدمت Rozado حوالي 5000 نقطة بيانات فقط لتحويل نموذج لغة موجود إلى RightWingGPT – يمكن للمبرمجين المستقلين استخدام هذه التقنية كطريقة تتبع سريع لإنشاء روبوتات محادثة تتماشى مع أهدافهم السياسية.

كما سمح هذا للسيد روزادو بتجاوز الاستثمار الهائل لإنشاء روبوت محادثة من الصفر. بدلاً من ذلك ، كلفه حوالي 300 دولار فقط.

حذر السيد روزادو من أن روبوتات الدردشة المخصصة للذكاء الاصطناعي يمكن أن تخلق “فقاعات معلومات على المنشطات” لأن الناس قد يثقون بها على أنهم “المصادر النهائية للحقيقة” – خاصة عندما كانوا يعززون وجهة النظر السياسية لشخص ما.

وردد نموذجه صدى نقاط الحديث السياسية والاجتماعية المحافظة بصراحة كبيرة. سيتحدث ، على سبيل المثال ، بشكل متوهج عن رأسمالية السوق الحرة أو يقلل من أهمية عواقب تغير المناخ.

كما أنها قدمت ، في بعض الأحيان ، بيانات غير صحيحة أو مضللة. عندما تم حثها على آرائها حول مواضيع حساسة أو نظريات المؤامرة اليمينية ، فإنها تشارك المعلومات الخاطئة المتوافقة مع التفكير اليميني.

عندما يُسأل ChatGPT عن العرق أو الجنس أو موضوعات حساسة أخرى ، فإنه يميل إلى السير بحذر ، لكنه يعترف بأن العنصرية والتحيز النظاميين هما جزء جذاب من الحياة الحديثة. يبدو أن RightWingGPT أقل استعدادًا للقيام بذلك.

لم يفرج السيد Rozado عن RightWingGPT علنًا ، على الرغم من أنه سمح لصحيفة New York Times باختبارها. وقال إن التجربة ركزت على دق ناقوس الخطر بشأن التحيز المحتمل في أنظمة الذكاء الاصطناعي وإظهار كيف يمكن للمجموعات السياسية والشركات تشكيل الذكاء الاصطناعي بسهولة لصالح أجنداتهم الخاصة.

قال الخبراء الذين عملوا في مجال الذكاء الاصطناعي إن تجربة السيد روزادو أظهرت مدى سرعة ظهور روبوتات المحادثة المسيسة.

أقر متحدث باسم OpenAI ، مبتكر ChatGPT ، أن النماذج اللغوية يمكن أن ترث التحيزات أثناء التدريب والتنقيح – العمليات التقنية التي لا تزال تنطوي على الكثير من التدخل البشري. وأضاف المتحدث أن أوبن إيه آي لم تحاول التأثير في النموذج في اتجاه سياسي أو آخر.

سام التمان ، الرئيس التنفيذي ، أقر الشهر الماضي أن ChatGPT “به أوجه قصور حول التحيز” لكنه قال إن الشركة تعمل على تحسين استجاباتها. هو في وقت لاحق كتب أن ChatGPT لم يكن يقصد به “أن يكون مؤيدًا أو ضد أي سياسة بشكل افتراضي” ، ولكن إذا أراد المستخدمون مخرجات حزبية ، فيجب أن يكون الخيار متاحًا.

في منشور مدونة نُشر في فبراير ، قالت الشركة إنها ستنظر في تطوير ميزات من شأنها أن تسمح للمستخدمين “بتحديد قيم الذكاء الاصطناعي الخاصة بك” ، والتي يمكن أن تتضمن مفاتيح تبديل تضبط التوجه السياسي للنموذج. وحذرت الشركة أيضًا من أن مثل هذه الأدوات يمكن ، إذا تم نشرها عشوائيًا ، أن تخلق “أنظمة ذكاء اصطناعي متملق تضخم بشكل طائش معتقدات الناس الحالية”.

تم إصدار نسخة مطورة من النموذج الأساسي لـ ChatGPT ، GPT-4 ، الأسبوع الماضي بواسطة OpenAI. في مجموعة من الاختبارات ، وجدت الشركة أن GPT-4 سجلت درجات أفضل من الإصدارات السابقة من حيث قدرتها على إنتاج محتوى حقيقي ورفض “طلبات المحتوى غير المسموح به”.

في ورقة نُشرت بعد وقت قصير من ظهورها لأول مرة ، حذرت شركة OpenAI من أنه مع اعتماد روبوتات الدردشة للذكاء الاصطناعي على نطاق أوسع ، يمكن أن يكون لها “إمكانات أكبر لتعزيز الأيديولوجيات الكاملة ، ووجهات النظر العالمية ، والحقائق والأكاذيب ، وترسيخها”.

تشانغ تشي ساهم في إعداد التقارير.